Files: https://strutive07.github.io/assets/images/5_6_Rethinking_of_SVM/IE661-Week_5-Part_3-icmoon-ver-1.pdf last update datetime: Mar 01, 2020 8:09 PM

이번 강의에서는 non-linear 한 SVM 을 만들기 위해 kernel trick을 배워보자.

기존의 soft margin SVM 을 생각해보자.

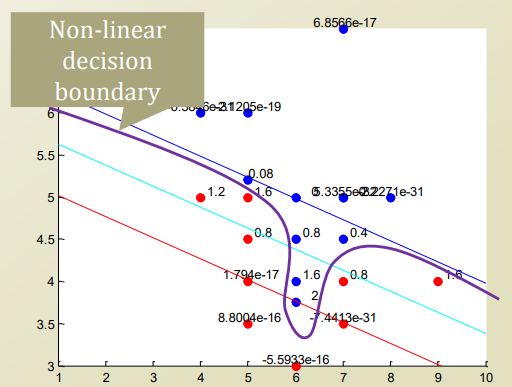

이런경우 decision boundary가 linear 할 경우 좋은 구분을 하기 힘들다.

None linear 하게 생각하면 이 데이터를 분류할 수 있을것이다.

어떻게?

일단 간단히 생각해보자.

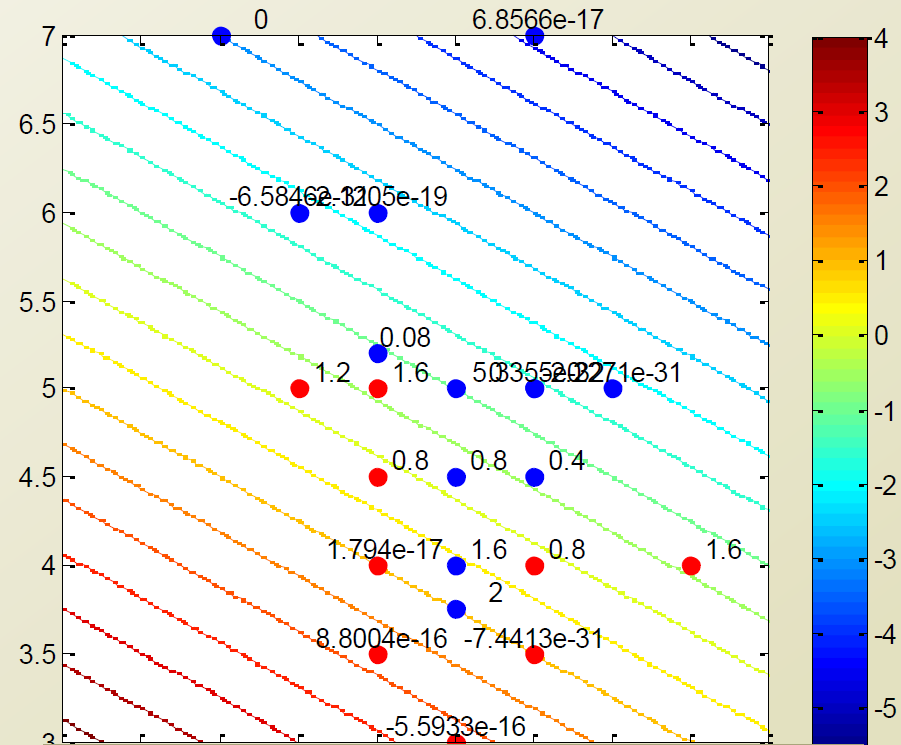

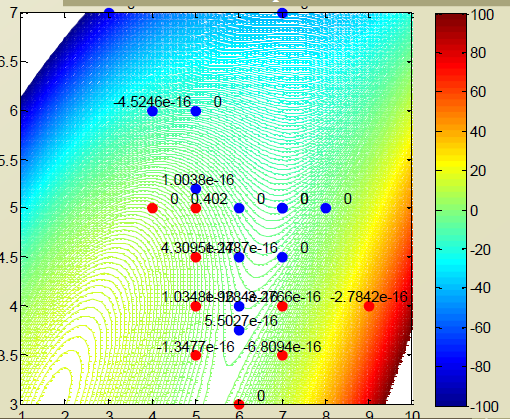

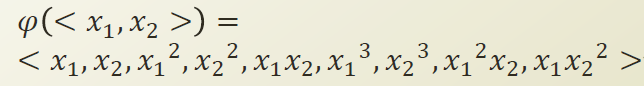

데이터의 차원을 늘리면 우리는 non-linear한 decision boundary를 만들 수 있을것이다. logistic regression에서 경험했듯이.

그럼 위에 그래프가 나올것이다. (결과를 다시 2차원으로 줄여서 본다면)

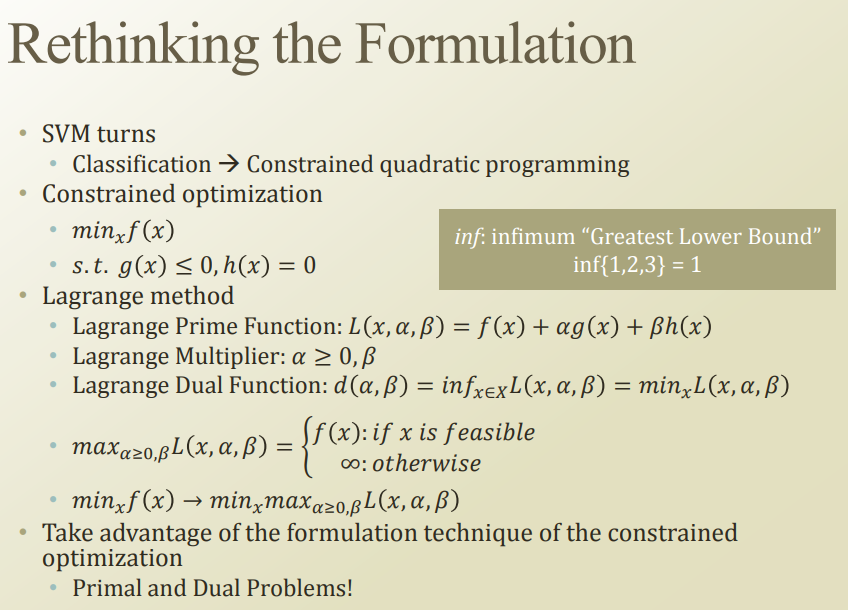

여기서 quadratic programming을 잘 알아야 내용을 이해할 수 있다.

SVM 은 Convex optimization 문제중 하나인, quadratic programming 으로 optimization 이 된다.

kernel SVM 에서는 duality 를 사용하는듯 하다. duality 를 사용할려면, Convex optimization 에서 배웠던 lagrange method를 사용해야한다.

관련 내용